人工智能中的监督学习和无监督学习

本文详细介绍了人工智能(AI)中监督学习和无监督学习的基本思想、具体过程,并通过四个复杂的代码实现案例对比了它们的区别。在监督学习中,我们通过使用已标注的数据集进行模型训练,目标是预测已知输出,如回归问题中的房价预测和分类问题中的图像分类。无监督学习则不使用标签数据,目标是从数据中发现潜在的模式或结构,如聚类中的客户分群和降维中的主成分分析(PCA)。通过对监督学习和无监督学习的详细讲解以及实际代

欢迎来到 Papicatch的博客

目录

🍉引言

人工智能(AI)中的机器学习(ML)可以根据学习方式分为几种主要类型,其中监督学习和无监督学习是两种最重要的方法。本文将介绍这两种学习方法的基本思想、具体过程,并提供四个复杂的代码实现案例来对比它们的区别。

🍉监督学习

🍈基本思想

监督学习是一种利用已知标签的数据进行训练的机器学习方法。其目标是学习一个函数,通过该函数可以将输入映射到相应的输出。监督学习可以分为两类:回归和分类。

- 回归:用于预测连续的数值,例如房价预测。

- 分类:用于预测离散的类别标签,例如图像分类。

🍈具体过程

🍍数据收集

收集带有标签的数据集,这些数据包含输入特征和对应的输出标签。

🍍数据预处理

清洗和整理数据,处理缺失值,进行特征选择和特征工程,确保数据质量。

🍍模型选择

选择适合问题的机器学习算法,例如线性回归、支持向量机、决策树、神经网络等。

🍍模型训练

使用训练数据集对模型进行训练,调整模型参数以最小化预测误差。

🍍模型评估

使用验证数据集评估模型性能,常用指标包括准确率、精确率、召回率、均方误差等。

🍍模型部署

将训练好的模型应用到实际数据中进行预测,并持续监控模型性能,进行必要的调整和改进。

🍉无监督学习

🍈基本思想

无监督学习是一种不使用标签数据进行训练的机器学习方法。其目标是从数据中发现潜在的模式或结构。无监督学习常见的方法有聚类和降维。

- 聚类:将数据分成多个组,每组中的数据具有相似性,例如客户分群。

- 降维:减少数据的维度,同时保持数据的重要特征,例如主成分分析(PCA)。

🍈具体过程

🍍数据收集

收集未标注的数据集,这些数据只包含输入特征。

🍍数据预处理

同样需要进行数据清洗和整理,确保数据质量。

🍍模型选择

选择适合问题的无监督学习算法,例如K-means、层次聚类、主成分分析等。

🍍模型训练

使用数据集对模型进行训练,以发现数据的结构或模式。

🍍结果分析

对模型输出的结果进行分析和解释,评估模型在实际应用中的表现。

🍉案例

🍈监督学习 - 房价预测(回归)

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# 数据加载

data = pd.read_csv('housing.csv')

# 数据预处理

X = data.drop('price', axis=1)

y = data['price']

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 模型选择与训练

model = LinearRegression()

model.fit(X_train, y_train)

# 模型评估

y_pred = model.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

print(f'Mean Squared Error: {mse}')

在这个案例中,我们使用线性回归算法预测房价。通过将数据集分为训练集和测试集,我们训练模型并评估其性能。

🍈监督学习 - 图像分类(分类)

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

from sklearn.metrics import classification_report

# 数据加载

(train_images, train_labels), (test_images, test_labels) = datasets.cifar10.load_data()

# 数据预处理

train_images, test_images = train_images / 255.0, test_images / 255.0

# 模型选择与训练

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(10)

])

model.compile(optimizer='adam', loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True), metrics=['accuracy'])

model.fit(train_images, train_labels, epochs=10, validation_data=(test_images, test_labels))

# 模型评估

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

print(f'Test accuracy: {test_acc}')

在这个案例中,我们使用卷积神经网络(CNN)进行图像分类任务。通过对CIFAR-10数据集进行训练和测试,我们评估模型的准确性。

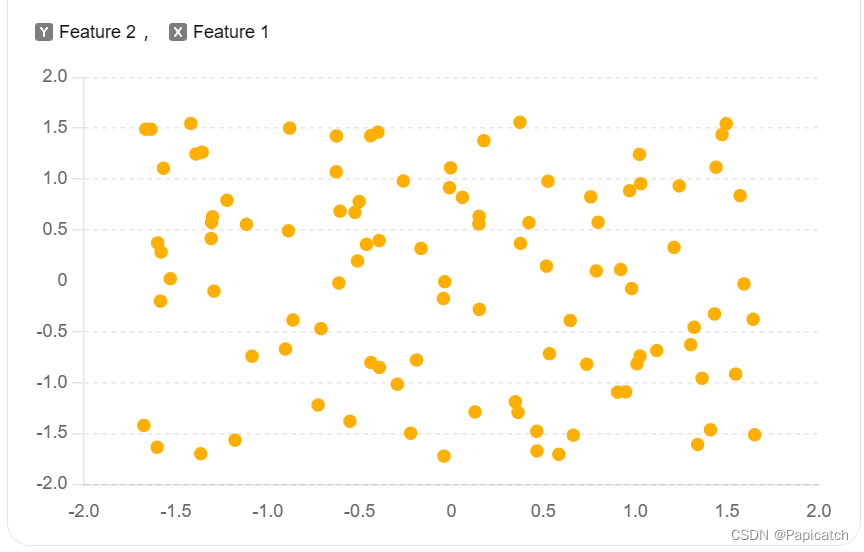

🍈无监督学习 - 客户分群(聚类)

import pandas as pd

from sklearn.preprocessing import StandardScaler

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

# 数据加载

data = pd.read_csv('customer_data.csv')

# 数据预处理

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data)

# 模型选择与训练

kmeans = KMeans(n_clusters=3, random_state=42)

kmeans.fit(data_scaled)

# 聚类结果

labels = kmeans.labels_

# 结果分析

plt.scatter(data_scaled[:, 0], data_scaled[:, 1], c=labels, cmap='viridis')

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.title('Customer Segmentation')

plt.show()

在这个案例中,我们使用K-means聚类算法对客户数据进行分群。通过数据标准化和K-means算法,我们可以发现数据中的自然分组。

🍈无监督学习 - 降维和可视化

import pandas as pd

from sklearn.decomposition import PCA

import matplotlib.pyplot as plt

# 数据加载

data = pd.read_csv('high_dimensional_data.csv')

# 数据预处理

data_cleaned = data.dropna() # 假设需要进行缺失值处理

# 模型选择与训练

pca = PCA(n_components=2) # 将数据降到2维

principal_components = pca.fit_transform(data_cleaned)

# 结果分析

plt.scatter(principal_components[:, 0], principal_components[:, 1], cmap='viridis')

plt.xlabel('Principal Component 1')

plt.ylabel('Principal Component 2')

plt.title('PCA of High Dimensional Data')

plt.show()

🍉对比监督学习和无监督学习的区别

🍈数据需求

- 监督学习需要带标签的数据,而无监督学习不需要标签数据。这意味着监督学习的应用更依赖于数据标注,而无监督学习可以应用于更多场景。

🍈目标

- 监督学习的目标是预测已知输出,例如分类或回归问题。

- 无监督学习的目标是发现数据中的潜在结构,例如聚类或降维。

🍈应用场景

- 监督学习常用于需要明确预测的任务,例如图像分类、股票价格预测、欺诈检测等。

- 无监督学习常用于探索性数据分析和特征提取,例如客户分群、数据降维、异常检测等。

🍈算法复杂度

- 监督学习算法通常需要大量标注数据进行训练,数据标注成本高,但模型训练和评估的过程相对明确。

- 无监督学习算法需要更复杂的模型和算法来从未标注数据中提取信息,尽管数据获取成本低,但结果的解释和验证可能更具挑战性。

🍈模型评估

- 监督学习的模型评估可以使用诸如准确率、精确率、召回率、均方误差等明确指标。

- 无监督学习的模型评估通常依赖于领域专家的解释和对数据模式的直觉理解,缺乏标准化的评估指标。

🍉总结

本文详细介绍了人工智能(AI)中监督学习和无监督学习的基本思想、具体过程,并通过四个复杂的代码实现案例对比了它们的区别。在监督学习中,我们通过使用已标注的数据集进行模型训练,目标是预测已知输出,如回归问题中的房价预测和分类问题中的图像分类。无监督学习则不使用标签数据,目标是从数据中发现潜在的模式或结构,如聚类中的客户分群和降维中的主成分分析(PCA)。

通过对监督学习和无监督学习的详细讲解以及实际代码实现,我们了解到这两种方法在数据需求、目标、应用场景、算法复杂度和模型评估方面的不同。监督学习需要大量标注数据进行训练,而无监督学习不需要标签数据,更适用于探索性数据分析和特征提取。监督学习的目标是预测明确的输出,而无监督学习则致力于发现数据中的隐藏结构。

在实际应用中,根据问题的具体需求选择合适的学习方法至关重要。希望通过本文的介绍和案例展示,读者能够对监督学习和无监督学习有更深入的理解,并能在实际项目中灵活运用这两种方法解决问题。

希望能给大家提供一些帮助!!!

开放原子开发者工作坊旨在鼓励更多人参与开源活动,与志同道合的开发者们相互交流开发经验、分享开发心得、获取前沿技术趋势。工作坊有多种形式的开发者活动,如meetup、训练营等,主打技术交流,干货满满,真诚地邀请各位开发者共同参与!

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)