【AI大模型】LLaMa羊驼大模型详解

LLaMa模型结构:前面的词预测后面的词,经典的解码结构。位置编码用的是旋转自编码。大语言模型为什么取名为LLaMa(美洲鸵)?LLM发音困难。两个LL跟绕口令一样挑战舌头。大家想给它加点原音,帮助发音。有人加了A,就是LLaMa。3.模型的训练和数据:65B的模型使用2048块A100 80G的GPU,训练21天左右。(训练成本还是比较高的,训练的数据集同GPT一样)LLaMa模型训练的数据集。

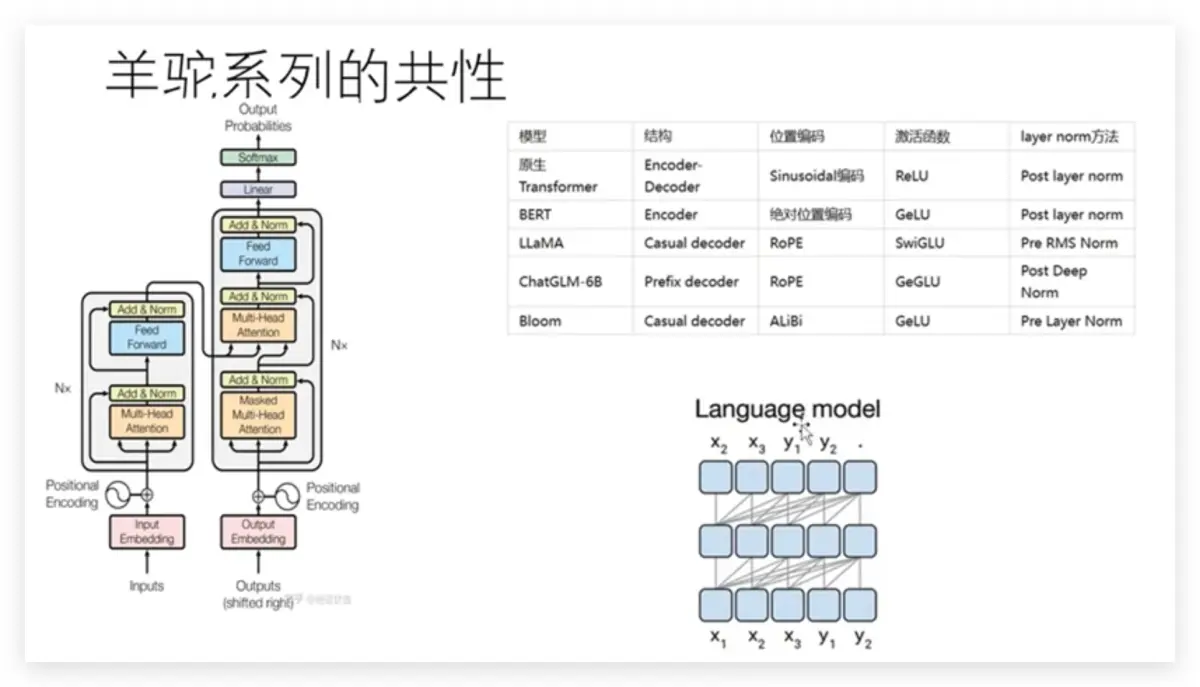

LLaMa系列模型

- 羊驼模型(鼻祖是LLaMa模型,Facebook公司开源模型):即将成为大模型的安卓,国内95%的大模型都是羊驼套壳。

- GPT系列(OpenAI公司):相当于大模型的iOS(不开源)。

LLaMa模型结构:前面的词预测后面的词,经典的解码结构。位置编码用的是旋转自编码。

大语言模型为什么取名为LLaMa(美洲鸵)?

LLM发音困难。两个LL跟绕口令一样挑战舌头。大家想给它加点原音,帮助发音。有人加了A,就是LLaMa。

- LLaMa是2023年Meta发布的基础LLM模型,该模型有四个版本,分别是7B、13B、33B、65B参数的模型。(LLaMa模型是从零开始训练的基础模型,国内大多数模型都是套壳LLaMa模型)

2.模型的优点:

- 开源。相比之前的大模型,LLaMa完全是在公共开源预训练数据上训练(通用性比较强,没有使用封闭的数据)

- 推理效率也是LLaMa的一个亮点,可以在单卡V100完成推理(降低了硬件使用门槛,让大模型平民化,训练模型的成本大大降低)。

3.模型的训练和数据:

65B的模型使用2048块A100 80G的GPU,训练21天左右。(训练成本还是比较高的,训练的数据集同GPT一样)

LLaMa模型训练的数据集

- 模型下载地址:https://huggingface.co(国内镜像网站:https://hf-mirror.com/models)

Alpaca模型

- Alpaca是斯坦福从Meta的LLaMA 7B微调而来的全新模型(套壳是微调模型,LLaMA是全调的基础模型),仅用了52k数据,性能约等于GPT-3.5。

- 训练成本奇低,不到600美元。(大模型屌丝化)

- 在8个80GB A100 上训练了3个小时,不到100美元;

- 生成数据使用OpenAl的API,500美元。(正常是人工来标注数据,人工的成本很高;这里数据标注使用了OpenAl的接口,问题问ChatGPT3,用它的回答作为标注数据来进行微调,训练出Alpaca模型)

国内很多大模型都是学Alpaca模型的玩法,套壳LLaMA模型低成本训练出自己的模型。

Alpaca模型的训练流程

Alpaca模型使用了GPT3来标注数据

Vicuna模型

Vicuna模型简介

Vicuna模型训练流程

Vicuna模型使用了GPT4来做评估(效果更好)

GPT5短时间暂时不会有,因为GPT4已经突破了人类现在的硬件资源的一个极限。

羊驼系列模型对比

羊驼系列模型对比

华驼大模型(国内的医疗大模型)

华驼大模型

百川大模型(搜狗王小川搞的大模型)

LLaMa + 中文数据

业内有句俗话:一开源就自主研发,不开源就卡脖子

LLaMa2的提升

模型的提升一般模型本身没有多大的进化, 主要的提升是堆数据和堆算力,使模型进行进化。

LLaMa2.0的训练也使用了ChatGPT的训练那套方法:

- 第一步:首先对LLaMa模型通过问答对进行有监督的训练

- 第二步:训练一个排序模型(就是通过人来标注这个模型输出的数据,让这个模型输出的答案更加符合人类的认知;通过人来对这些输出的结果打分,来调整这个模型,让这个模型的输出结果更加符合人的认知);这个强化模型,就相当于具备了人的情商,理解了人类的喜好。

- 第三步:用具备人类喜好的这个模型,再来去微调LLaMa,让这个LLaMa模型输出的结果更加符合人的认知(相当于具备了情商),这样就训练出LLaMa2.0。

微调的效果为什么会好?

原生的基础LLaMa用的语料是通用语料。在自己的数据上进行微调,让模型能够满足自己的需求。微调的本质并不是能把模型效果变好,微调的目的是让模型更适应于我们的数据。

如何学习大模型AI

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

小编自己也在一线互联网工作十余年了,意识到有很多经验和知识值得分享给大家,也可以通过我的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、大模型全套的学习路线

学习大型人工智能模型,如GPT-3、BERT或任何其他先进的神经网络模型,需要系统的方法和持续的努力。既然要系统的学习大模型,那么学习路线是必不可少的,下面的这份路线能帮助你快速梳理知识,形成自己的体系。

L1级别:AI大模型时代的华丽登场

L2级别:AI大模型API应用开发工程

L3级别:大模型应用架构进阶实践

L4级别:大模型微调与私有化部署

一般掌握到第四个级别,市场上大多数岗位都是可以胜任,但要还不是天花板,天花板级别要求更加严格,对于算法和实战是非常苛刻的。建议普通人掌握到L4级别即可。

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

开放原子开发者工作坊旨在鼓励更多人参与开源活动,与志同道合的开发者们相互交流开发经验、分享开发心得、获取前沿技术趋势。工作坊有多种形式的开发者活动,如meetup、训练营等,主打技术交流,干货满满,真诚地邀请各位开发者共同参与!

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)