本地知识库搭建之路:从零到一

通过以上步骤,我成功搭建了本地知识库,并实现了与大模型的连接。这个过程虽然简单,但却让我深刻体会到人工智能的强大力量。我相信,随着人工智能技术的不断发展,它将为我们的生活和工作带来更多便利和惊喜。下一步计划我将继续学习人工智能相关知识,探索更多有趣的应用场景。未来,我希望能够利用人工智能技术解决更多实际问题,为社会创造更大的价值。参考文件:pwd=37aapwd=we1k让我们一起拥抱人工智能,开

在信息爆炸的时代,如何高效地管理和利用知识,成为了一个重要课题。幸运的是,人工智能技术为我们提供了强大的工具,帮助我们搭建本地知识库,实现知识的高效管理和智能问答。今天,中羊将回顾我昨天的学习经历,带你一起仔细探索本地知识库的搭建之路。

第一步:搭建本地 AI 环境

1.1 下载并安装 Llama3

Llama3 是 Meta 公司发布的开源大模型,拥有强大的推理和生成能力。我们可以通过以下步骤在本地部署 Llama3:

-

下载 Ollama 软件:Ollama 是 Llama3 的客户端,用于与模型进行交互。您可以从 公众号:郭震AI 获取 Ollama 软件下载流程,并按照指引进行安装。

-

安装 Llama3 模型:在终端中输入

ollama run llama3命令,Ollama 会自动下载并安装 Llama3 模型。打开一个终端窗口,再次输入 ollama run llama3 命令就会自动启动会话页面。

发送第一条消息,你是谁,用中文回答。

1.2 搭建 AI 网站

为了让 Llama3 的使用更加便捷,我们可以搭建一个 AI 网站,实现图形化交互。

-

下载并安装 Docker:Docker 是一个开源的容器化平台,可以帮助我们快速部署和管理应用。您可以从 Docker 官网下载并安装 Docker。

docker下载官网:Docker Desktop: The #1 Containerization Tool for Developers | Docker

-

使用 Docker 部署 LobeChat:LobeChat 是一个开源的聊天机器人框架,可以与多种大模型进行交互。

-

启动 LobeChat 网站:打开浏览器,输入

localhost:10084,即可进入 LobeChat 网站。

LobeChat 的界面非常美观,操作也非常简单。它让我可以更方便地使用 Llama3 进行智能问答。

第二步:搭建本地知识库

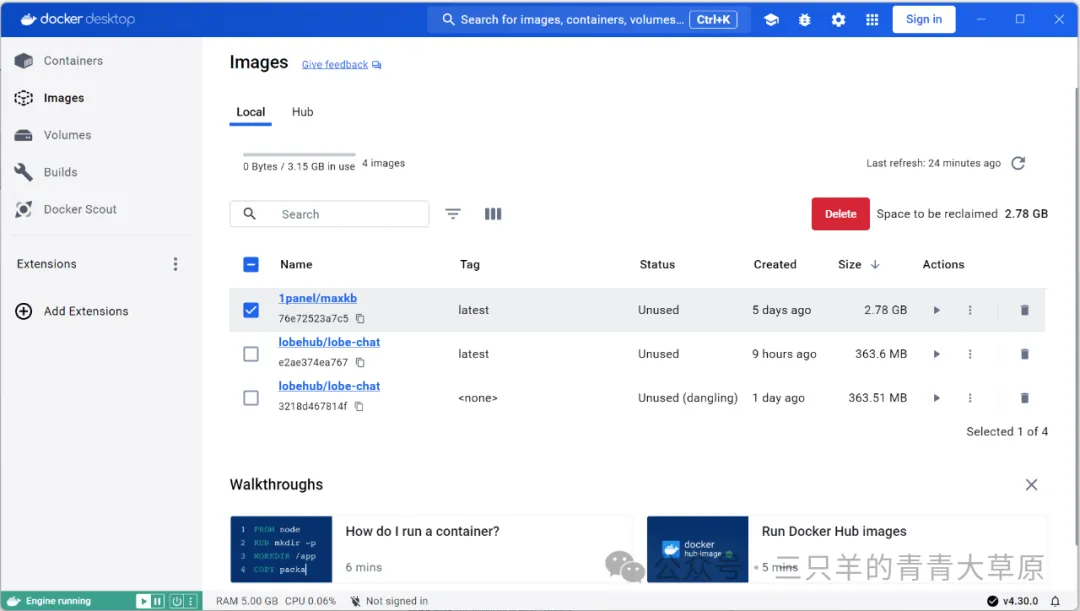

2.1 下载并安装 MaxKB

MaxKB 是一个开源的知识库问答系统,支持多种大语言模型,可以帮助我们搭建和管理本地知识库。

- 下载 MaxKB 镜像:使用以下命令下载 MaxKB 镜像:

docker pull maxkb/maxkb:latest

- 配置 MaxKB 容器:打开 Docker,创建一个新的容器,并将 MaxKB 镜像映射到本地端口。

-

端口映射:将本地端口映射到 MaxKB 容器的端口,例如

8080:8080。 -

数据卷:指定一个本地文件夹作为知识库数据存储路径。

-

环境变量:设置一些环境变量,例如数据库连接信息。

-

启动 MaxKB 容器:点击“运行”按钮,启动 MaxKB 容器。

MaxKB 的安装过程也非常简单,只需要在 Docker 中进行一些配置就能完成。

2.2 创建知识库

-

登录 MaxKB:打开浏览器,输入

localhost:8080,使用初始账号admin和密码MaxKB@123登录 MaxKB。 -

创建知识库:点击“知识库”标签,然后点击“创建知识库”按钮,填写知识库名称、描述等信息。

- 导入文档: 选择文档导入方式,例如上传文件或读取文件夹。您可以将您的文档、笔记等资料导入到知识库中。

MaxKB 支持多种文档格式,并且可以自动分析和索引文档内容,非常方便。

2.3 配置 Llama3 模型

-

进入模型设置界面:点击“系统设置”标签,然后点击“模型设置”按钮。

-

添加 Llama3 模型:填写 Llama3 模型的配置信息,例如模型路径、参数等。

将 Llama3 模型与知识库关联起来,可以实现对文档内容的智能问答,功能非常强大。

2.4 创建知识库应用

-

进入应用管理界面:点击“应用”标签,然后点击“创建应用”按钮。

-

填写应用信息:填写应用名称、描述等信息,并选择 Llama3 模型。

-

启动应用:点击“启动”按钮,启动知识库应用。

知识库应用启动后,您就可以通过它进行文档搜索和智能问答了。

总结

通过以上步骤,我成功搭建了本地知识库,并实现了与大模型的连接。这个过程虽然简单,但却让我深刻体会到人工智能的强大力量。我相信,随着人工智能技术的不断发展,它将为我们的生活和工作带来更多便利和惊喜。

下一步计划

我将继续学习人工智能相关知识,探索更多有趣的应用场景。未来,我希望能够利用人工智能技术解决更多实际问题,为社会创造更大的价值。

参考文件:

https://pan.baidu.com/s/1iExIbQkQJ97t5TDh51bVdw?pwd=37aa

https://pan.baidu.com/s/1NlhqIRdNLe95ImSqybUd9Q?pwd=we1k

让我们一起拥抱人工智能,开启智能生活的新篇章!

如何学习大模型 AGI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

-END-

👉AGI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉AGI大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉AGI大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

开放原子开发者工作坊旨在鼓励更多人参与开源活动,与志同道合的开发者们相互交流开发经验、分享开发心得、获取前沿技术趋势。工作坊有多种形式的开发者活动,如meetup、训练营等,主打技术交流,干货满满,真诚地邀请各位开发者共同参与!

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)