全球最强端侧多模态模型!国产「面壁小钢炮」MiniCPM-Llama3-V 2.5 来了!

得益于 VisCPM 的跨语言泛化技术,在中英双语多模态能力的基础上,MiniCPM-Llama3-V 2.5 仅通过少量翻译的多模态数据的指令微调,高效泛化支持了德语、法语、西班牙语、意大利语、俄语等 30+ 种语言的多模态能力,几乎覆盖了所有一带一路的国家,意味着全球上百个国家的数十亿人口,都能与 MiniCPM-Llama3-V 2.5 丝滑交互。OCR 技术进一步打磨,复杂推理与多模态识别

文章目录

如果说 2023 年是生成式 AI 爆发的元年,那么各路厂商今年难得一见地达成了共识——全力押注端侧大模型。

过去一年,由于 6B、7B 等小模型的成果井喷,以及 MoE 训练技术的越发成熟,将模型跑在手机、学习机、平板电脑、机器人甚至汽车等等终端应用上的想象力开始变大,无论算法层还是硬件层都「蠢蠢欲动」。诚然,这已经成为一个明朗的行业方向,但在系统整合上却要面临不同话语体系之间的博弈。

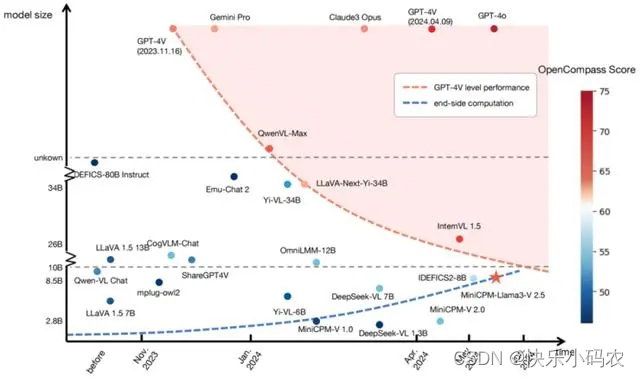

下面这张图反映了在全球范围内,小参数、高性能的多模态大模型已经成为趋势。

图注:OpenCompass 榜单变化显示,小参数、高性能模型逐渐成为 AI 技术趋势

昨日,「面壁智能」推出了最强端侧多模态开源模型 MiniCPM-Llama3-V 2.5。 仅用8B参数,击败了OpenAI的 GPT-4V 和谷歌的 Gemini Pro,而且,其 OCR 长难图识别刷新SOTA,图像编码速度暴涨150倍,成为全球最强端侧多模态模型!

总结一下,MiniCPM-Llama3-V 2.5的主要特点和优势:

- 多模态能力飞升:参数规模仅 8B,综合性能却超越谷歌的多模态巨无霸 Gemini Pro 与 OpenAI 的 GPT-4V;

- OCR 能力 SOTA:能够精准识别长图、难图与长文本,9 倍像素更清晰,同时具备识别与推理能力;

- 手机端突破:首次整合 NPU 和 CPU 加速框架, 对手机端多模态大模型进行系系统级加速,速度提升 150 倍;

- 多语种能力:支持 30 多种语言,除了中英双语,还包括法语、德语、西班牙语等等主流语言,基本覆盖了一带一路的所有国家;

MiniCPM-Llama3-V 2.5开源地址:https://github.com/OpenBMB/MiniCPM-V

MiniCPM系列开源地址:https://github.com/OpenBMB/MiniCPM

Hugging Face下载地址:https://huggingface.co/openbmb/MiniCPM-Llama3-V-2_5

1. 最强端侧多模态 SOTA 诞生:「以小博大」的 MiniCPM-Llama3-V 2.5

MiniCPM-Llama3-V 2.5 在评测平台 OpenCompass 得分 65.1,不仅比肩闭源模型 Qwen-VL-Max,综合性能还力压重量级选手 GPT-4V 和 Gemini Pro。

OCR(光学字符识别)是多模态大模型最重要的能力之一,也是考察多模态识别与推理能力的硬核指标。

在 OCR 综合基准测试中,MiniCPM-Llama3-V 2.5 取得了 725 分的SOTA成绩,远超 GPT-4V,越级超越了Claude 3V Opus、Gemini Pro等标杆模型。

图注:模型雷达图,MiniCPM-Llama3-V 2.5 综合能力水平全面优秀

OCR 技术进一步打磨,复杂推理与多模态识别能力再进化,MiniCPM-Llama3-V 2.5 对于难图、长图、长文本的精准识别,再度带来出众表现!

依托于面壁自研高清图像高效编码技术,MiniCPM-Llama3-V 2.5 支持高效编码及无损识别 180 万高清像素图片,并且支持任意长宽比——即便是 1:9 的极限比例图像,突破了传统技术仅能识别20万像素小图的瓶颈。

在评估多模态大模型性能可靠性的重要指标——幻觉能力上,MiniCPM-Llama3-V 2.5 在Object HalBench榜单上超越了GPT-4V等众多模型(注:目标幻觉率应为0)。

RealWorldQA 基准测试是一场检验模型现实理解力的大考。

在RealWorldQA榜单上,MiniCPM-Llama3-V 2.5 交出了 63.5 的答卷,仅次于 InternVL-Chat-V1.5 (26B),再次超越GPT-4V和Gemini Pro。

2. 快150倍!多语种能力增强!端侧高效部署!

2.1 支持30+多种语言

面壁 MiniCPM-Llama3-V 2.5 的另外两项优势体现在多语种能力与端侧部署加速上。

得益于 VisCPM 的跨语言泛化技术,在中英双语多模态能力的基础上,MiniCPM-Llama3-V 2.5 仅通过少量翻译的多模态数据的指令微调,高效泛化支持了德语、法语、西班牙语、意大利语、俄语等 30+ 种语言的多模态能力,几乎覆盖了所有一带一路的国家,意味着全球上百个国家的数十亿人口,都能与 MiniCPM-Llama3-V 2.5 丝滑交互。

在对话中,MiniCPM-Llama3-V2.5 表现出了良好的多语言多模态对话性能。

与目前国内较为领先的零一万物多模态模型 Yi-VL 34B 为参照,多语言版本 LLaVABench 评测结果显示,MiniCPM-Llama3-V2.5 对话能力更胜一筹。

图注:多语言版本LLaVABench评测结果,MiniCPM-Llama3-V 2.5对话能力更胜一筹

图注:多语言案例展示

2.2 图像编码快150倍!端侧高效部署!

首次进行端侧系统级加速,MiniCPM-Llama3-V 2.5已高效部署手机。

在图像编码方面,面壁首次整合NPU和CPU加速框架,在 MiniCPM-Llama3-V 2.5 图像编码方面实现了 150 倍加速提升。

举例来说,Llama 3 语言模型在手机端侧的解码速度在 0.5 token/s 上下,而多模态模型 MiniCPM-Llama3-V 2.5 经过 CPU 等多重优化方式,使得在手机端的语言解码速度提升到 3-4 token/s。

参考:

https://github.com/OpenBMB/MiniCPM-V

欢迎各位关注我的个人微信公众号:HsuDan,我将分享更多自己的学习心得、避坑总结、面试经验、AI最新技术资讯。

开放原子开发者工作坊旨在鼓励更多人参与开源活动,与志同道合的开发者们相互交流开发经验、分享开发心得、获取前沿技术趋势。工作坊有多种形式的开发者活动,如meetup、训练营等,主打技术交流,干货满满,真诚地邀请各位开发者共同参与!

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)