Video Caption的常用数据集(持续更新)

虽然人们对用自然语言描述视频的任务越来越感兴趣,但目前的计算机视觉算法在视频及其可以识别的相关语言的可变性和复杂性方面仍然受到严重限制。这在一定程度上是由于当前基准测试的简单性,这些基准测试主要集中在特定的细粒度领域,具有有限的视频和简单的描述。虽然研究人员已经为图像字幕提供了几个基准数据集,但我们不知道有任何大规模的视频描述数据集具有全面的类别和多样化的视频内容。在本文中,我们提出了MSR-VT

MSR-VTT:用于桥接视频和语言的大型视频描述数据集

来源:

MSR-VTT: A Large Video Description Dataset for Bridging Video and Language - Microsoft Research

简介:

虽然人们对用自然语言描述视频的任务越来越感兴趣,但目前的计算机视觉算法在视频及其可以识别的相关语言的可变性和复杂性方面仍然受到严重限制。这在一定程度上是由于当前基准测试的简单性,这些基准测试主要集中在特定的细粒度领域,具有有限的视频和简单的描述。虽然研究人员已经为图像字幕提供了几个基准数据集,但我们不知道有任何大规模的视频描述数据集具有全面的类别和多样化的视频内容。

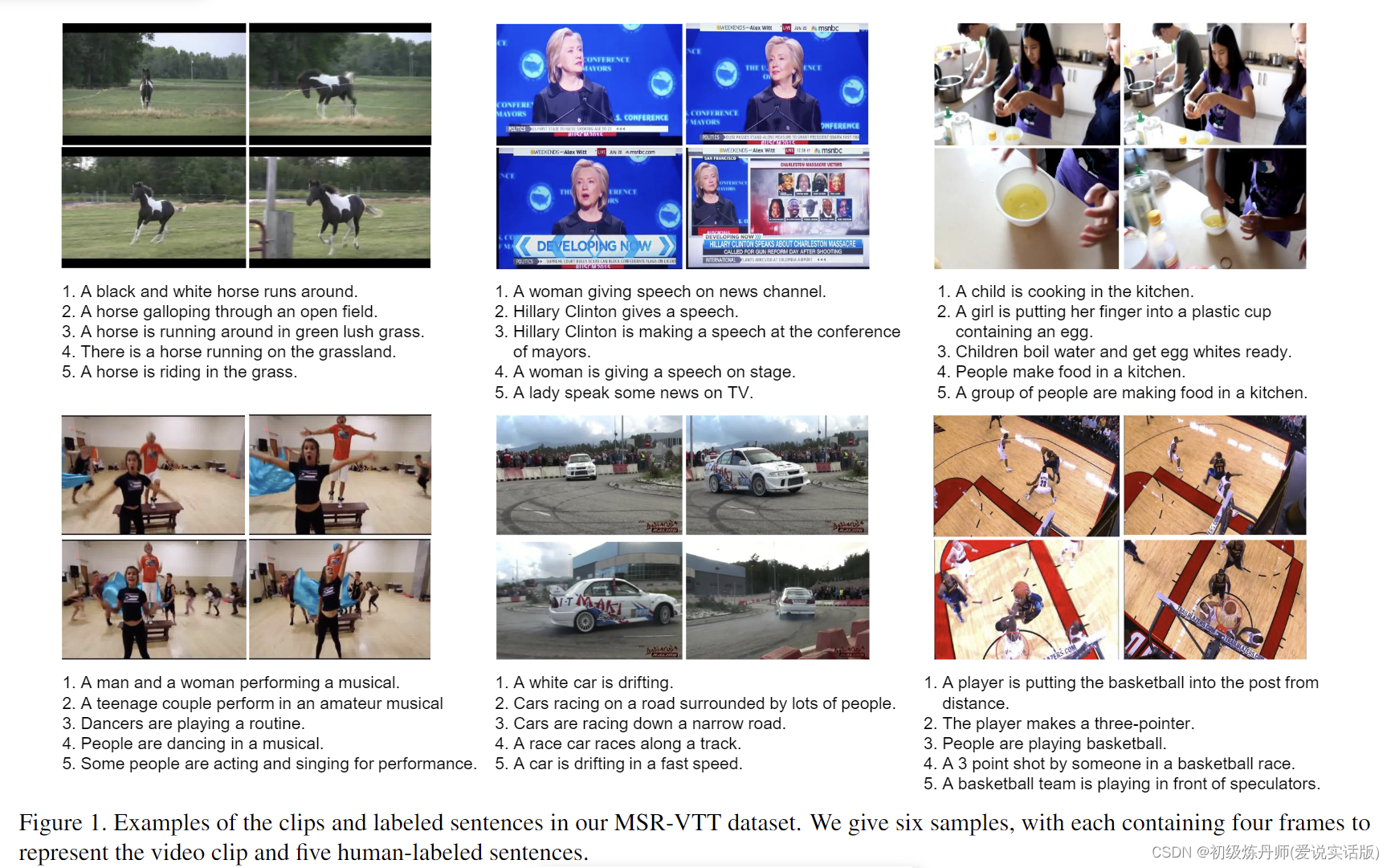

在本文中,我们提出了MSR-VTT(代表“MSR视频到文本”),这是一种用于视频理解的新型大规模视频基准,特别是将视频转换为文本的新兴任务。这是通过从商业视频搜索引擎收集 257 个热门查询来实现的,每个查询有 118 个视频。在当前版本中,MSR-VTT 提供 10K 网络视频剪辑,时长 41.2 小时,剪辑-句子对共计 200K,涵盖最全面的类别和多样化的视觉内容,在句子和词汇方面代表了最大的数据集。每个片段都用 1,327 名 AMT 工作人员的大约 20 个自然句子进行注释。我们将 MSR-VTT 与一整套现有数据集进行了详细分析,并总结了不同的最先进的视频转文本方法。我们还在该数据集上对这些方法进行了广泛的评估,表明基于混合递归神经网络的方法将单帧和运动表示与软注意力池策略相结合,在 MSR-VTT 上产生了最佳的泛化能力。

下载地址:

MSVD (Microsoft Research Video Description Corpus)

来源:MSVD Dataset | Papers With Code

简介:

微软研究视频描述语料库(MSVD)数据集由2010年夏天收集的约120K个句子组成。“土耳其机器人”的工作人员被要求观看一个简短的视频片段,然后用一句话总结这个动作。结果是一组对2000多个视频片段的大致平行的描述。因为工作人员被要求用自己选择的语言完成任务,所以数据中包含了意译和双语替代。

下载地址:

ActivityNet Captions

来源:

简介:

ActivityNet Captions数据集是建立在ActivityNet v1.3基础上的,其中包括2万个YouTube未剪辑视频,具有10万个字幕注释。这些视频平均长达120秒。大多数视频包含3个以上的带有对应开始/结束时间和人工撰写句子的注释事件,平均包含13.5个单词。训练/验证/测试集中的视频数量分别为10024/4926/5044。

下载地址:

HowTo100M

来源:HowTo100M (ens.fr)

简介:

HowTo100M是一个大型的叙事视频数据集,重点是教学视频,内容创作者教授复杂的任务,明确地解释屏幕上的视觉内容。HowTo100M共有以下功能:

1.36亿视频剪辑,字幕来自120万Youtube视频(15年视频)

23k个活动,包括烹饪、手工制作、个人护理、园艺或健身

每个视频都有一个从Youtube上自动下载的字幕。

下载地址:HowTo100M (ens.fr)

YouCook2

来源:YouCook2: Large-scale Cooking Video Dataset for Procedure Understanding and Description Generation (umich.edu)

简介:

YouCook2是视觉社区中最大的面向任务的教学视频数据集之一。它包含来自89个烹饪食谱的2000个未经修剪的长视频;平均而言,每个不同的食谱有22个视频。每个视频的步骤都标注了时间边界,并用祈使句来描述(见下面的例子)。这些视频是从YouTube下载的,都是第三人称视角。所有的视频都是不受限制的,可以由个人在他们的房子里用不固定的摄像机来表演。YouCook2包含丰富的食谱类型和来自世界各地的各种烹饪风格。浏览数据集或阅读更多详细信息。

YouCook2目前适用于视频语言研究、视频中的弱监督活动和对象识别、跨视频的共同对象和动作发现以及过程学习。

(新!)我们发布了食谱文本中对象的密集边界框注释。你可以在这里阅读或下载更多内容。

下载地址:

youcook2.eecs.umich.edu/download

ViTT (Video Timeline Tags)

来源:

简介:

ViTT数据集由8,169个视频的人工生成的片段级注释组成。其中,5840个视频标注了一次,其余视频标注了两次或两次以上。总共发布了12,461组注释。数据集中的视频来自Youtube-8M数据集。

下载地址:

特别鸣谢:

用于video captioning的数据集msr-vtt等如何下载? - 小彭的回答 - 知乎

https://www.zhihu.com/question/413486319/answer/3195460238

开放原子开发者工作坊旨在鼓励更多人参与开源活动,与志同道合的开发者们相互交流开发经验、分享开发心得、获取前沿技术趋势。工作坊有多种形式的开发者活动,如meetup、训练营等,主打技术交流,干货满满,真诚地邀请各位开发者共同参与!

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

https://cs.stanford.edu/people/ranjaykrishna/densevid/

https://cs.stanford.edu/people/ranjaykrishna/densevid/

所有评论(0)