CVPR 2024论文与代码汇总:计算机视觉领域最新研究进展

CVPR 2024的论文涵盖了计算机视觉领域的多个研究方向,包括但不限于3D场景表示、多模态大语言模型、目标检测、扩散模型等。这些研究工作不仅推动了学术前沿的发展,也为实际应用提供了新的技术支持。多模态融合成为热点,特别是视觉与语言的深度结合。3D表示和渲染技术取得重要突破,高斯散射等新方法展现出巨大潜力。生成模型,尤其是扩散模型,在各种视觉任务中的应用不断拓展。实时性和效率优化仍是研究重点,多个

CVPR 2024论文与代码汇总:计算机视觉领域最新研究进展

计算机视觉与模式识别会议(CVPR)作为计算机视觉领域最具影响力的学术会议之一,每年都会吸引全球顶尖研究机构和企业提交大量高质量论文。CVPR 2024即将于今年6月在美国西雅图举行,目前已经公布了部分接收论文名单。本文将对CVPR 2024的论文及其开源代码进行全面梳理和总结,为读者呈现计算机视觉领域的最新研究进展。

3D高斯散射(3D Gaussian Splatting)

3D高斯散射是近期兴起的一种新型三维场景表示和渲染方法,相比于神经辐射场(NeRF)具有更快的渲染速度和更好的细节表现。CVPR 2024在该方向上接收了多篇高质量论文:

- Scaffold-GS: Structured 3D Gaussians for View-Adaptive Rendering

该论文提出了一种结构化的3D高斯表示方法,通过引入空间结构信息来提高渲染质量和效率。论文主页:Scaffold-GS: Structured 3D Gaussians for View-Adaptive Rendering

- GPS-Gaussian: Generalizable Pixel-wise 3D Gaussian Splatting for Real-time Human Novel View Synthesis

这项工作专注于人体新视角合成任务,提出了一种可泛化的像素级3D高斯散射方法,实现了实时渲染。项目主页:Projectpage of GPS-Gaussian

- GaussianAvatar: Towards Realistic Human Avatar Modeling from a Single Video via Animatable 3D Gaussians

该论文将3D高斯散射应用于人体avatar建模,仅需单个视频即可生成可动画的逼真人体模型。代码开源地址:GitHub - aipixel/GaussianAvatar: [CVPR 2024] The official repo for "GaussianAvatar: Towards Realistic Human Avatar Modeling from a Single Video via Animatable 3D Gaussians"

![]()

- GaussianEditor: Swift and Controllable 3D Editing with Gaussian Splatting

这项工作聚焦于3D场景编辑,提出了一种基于高斯散射的快速可控编辑方法。代码已在GitHub开源:GitHub - buaacyw/GaussianEditor: [CVPR 2024] GaussianEditor: Swift and Controllable 3D Editing with Gaussian Splatting

- Deformable 3D Gaussians for High-Fidelity Monocular Dynamic Scene Reconstruction

该论文提出了可变形3D高斯模型,用于从单目视频重建高保真动态场景。项目主页:Deformable 3D Gaussians for High-Fidelity Monocular Dynamic Scene Reconstruction

这些工作从不同角度推动了3D高斯散射技术的发展,为三维场景表示和渲染开辟了新的研究方向。

多模态大语言模型(MLLM)

随着大语言模型(LLM)的蓬勃发展,将视觉能力赋予LLM成为了研究热点。CVPR 2024收录了多篇关于多模态大语言模型的论文:

- mPLUG-Owl2: Revolutionizing Multi-modal Large Language Model with Modality Collaboration

该论文提出了一种新的多模态协作机制,显著提升了模型的多模态理解和生成能力。代码已开源:mPLUG-Owl/mPLUG-Owl2 at main · X-PLUG/mPLUG-Owl · GitHub

- Link-Context Learning for Multimodal LLMs

这项工作引入了链接上下文学习方法,增强了多模态LLM的跨模态关联能力。代码地址:GitHub - isekai-portal/Link-Context-Learning

- OPERA: Alleviating Hallucination in Multi-Modal Large Language Models via Over-Trust Penalty and Retrospection-Allocation

该论文针对多模态LLM的幻觉问题,提出了过度信任惩罚和回顾分配机制。项目代码:GitHub - shikiw/OPERA: [CVPR 2024 Highlight] OPERA: Alleviating Hallucination in Multi-Modal Large Language Models via Over-Trust Penalty and Retrospection-Allocation

- Making Large Multimodal Models Understand Arbitrary Visual Prompts

这项工作探索了如何让多模态LLM理解任意视觉提示,大幅提升了模型的视觉理解能力。项目主页:ViP-LLaVA

- Chat-UniVi: Unified Visual Representation Empowers Large Language Models with Image and Video Understanding

该论文提出了一种统一的视觉表示方法,赋予LLM同时理解图像和视频的能力。代码开源地址:GitHub - PKU-YuanGroup/Chat-UniVi: [CVPR 2024 Highlight🔥] Chat-UniVi: Unified Visual Representation Empowers Large Language Models with Image and Video Understanding

这些研究工作从不同角度推动了多模态大语言模型的发展,为构建更强大的视觉-语言AI系统奠定了基础。

目标检测(Object Detection)

目标检测作为计算机视觉的基础任务之一,一直是CVPR的研究热点。今年CVPR在该方向也收录了多篇创新性工作:

- DETRs Beat YOLOs on Real-time Object Detection

该论文证明了基于DETR的方法在实时目标检测任务上可以超越YOLO系列模型,打破了以往的认知。代码已开源:GitHub - lyuwenyu/RT-DETR: [CVPR 2024] Official RT-DETR (RTDETR paddle pytorch), Real-Time DEtection TRansformer, DETRs Beat YOLOs on Real-time Object Detection. 🔥 🔥 🔥

- Boosting Object Detection with Zero-Shot Day-Night Domain Adaptation

这项工作聚焦于日夜场景的域适应问题,提出了一种零样本的域适应方法来提升检测性能。项目代码:GitHub - ZPDu/DAI-Net: [CVPR 2024] Boosting Object Detection with Zero-Shot Day-Night Domain Adaptation

- YOLO-World: Real-Time Open-Vocabulary Object Detection

该论文将开放词汇的能力引入YOLO框架,实现了实时的开放词汇目标检测。代码地址:GitHub - AILab-CVC/YOLO-World: [CVPR 2024] Real-Time Open-Vocabulary Object Detection

- Salience DETR: Enhancing Detection Transformer with Hierarchical Salience Filtering Refinement

这项工作通过引入层次化显著性过滤机制来增强DETR模型的检测性能。项目代码:GitHub - xiuqhou/Salience-DETR: [CVPR 2024] Official implementation of the paper "Salience DETR: Enhancing Detection Transformer with Hierarchical Salience Filtering Refinement"

这些研究从不同角度推动了目标检测技术的发展,为构建更高效、更准确的检测系统提供了新的思路。

扩散模型(Diffusion Models)

扩散模型作为生成模型的新范式,在图像生成、编辑等任务上展现出了强大的性能。CVPR 2024收录了多篇关于扩散模型的创新工作:

- InstanceDiffusion: Instance-level Control for Image Generation

该论文提出了一种实例级控制的图像生成方法,可以精确控制生成图像中的各个实例。项目主页:InstanceDiffusion: Instance-level Control for Image Generation

- Residual Denoising Diffusion Models

这项工作提出了残差去噪扩散模型,通过引入残差学习来提升模型性能。代码开源地址:GitHub - nachifur/RDDM: CVPR 2024: Residual Denoising Diffusion Models

- DeepCache: Accelerating Diffusion Models for Free

该论文提出了一种无需额外训练的扩散模型加速方法,大幅提升了推理速度。项目代码:GitHub - horseee/DeepCache: [CVPR 2024] DeepCache: Accelerating Diffusion Models for Free

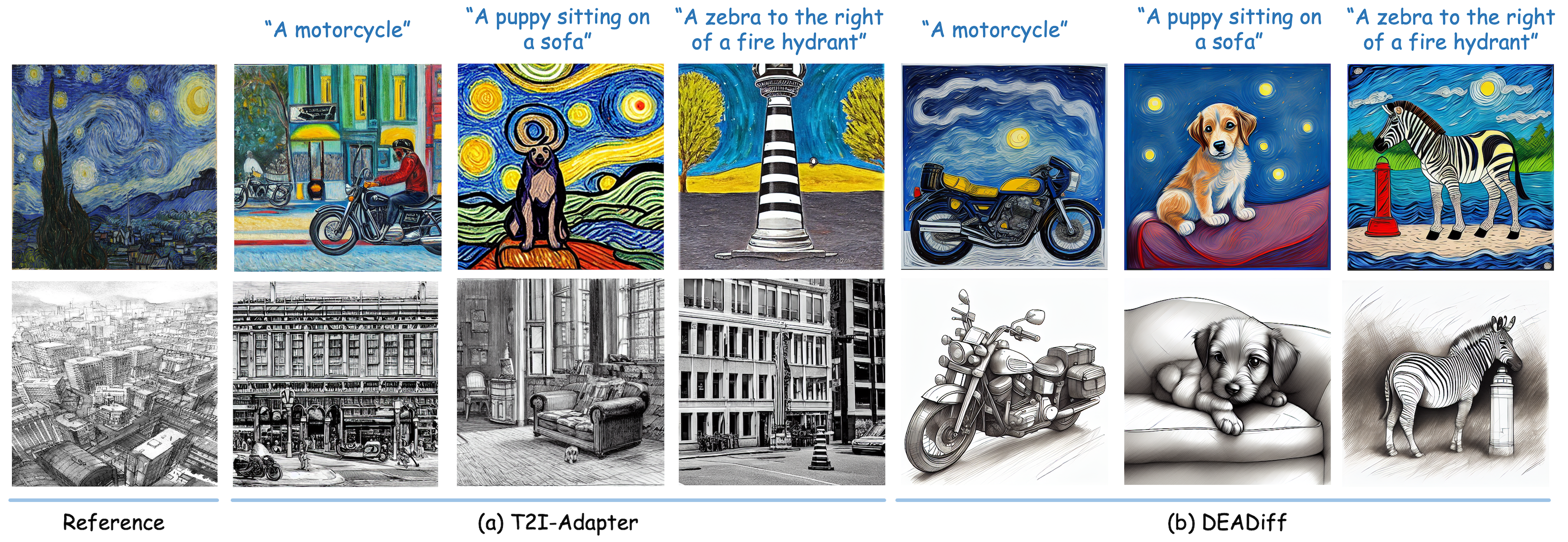

- DEADiff: An Efficient Stylization Diffusion Model with Disentangled Representations

这项工作聚焦于风格化扩散模型,通过解耦表示来提高生成效率和质量。项目主页:DEADiff: An Efficient Stylization Diffusion Model with Disentangled Representations

- SVGDreamer: Text Guided SVG Generation with Diffusion Model

该论文将扩散模型应用于SVG图像生成,实现了文本引导的矢量图生成。项目主页:SVGDreamer: Text Guided SVG Generation with Diffusion Model

这些研究工作从不同角度推动了扩散模型的发展,为构建更强大、更灵活的生成模型奠定了基础。

总结与展望

CVPR 2024的论文涵盖了计算机视觉领域的多个研究方向,包括但不限于3D场景表示、多模态大语言模型、目标检测、扩散模型等。这些研究工作不仅推动了学术前沿的发展,也为实际应用提供了新的技术支持。

值得注意的是,今年的研究趋势呈现出以下特点:

- 多模态融合成为热点,特别是视觉与语言的深度结合。

- 3D表示和渲染技术取得重要突破,高斯散射等新方法展现出巨大潜力。

- 生成模型,尤其是扩散模型,在各种视觉任务中的应用不断拓展。

- 实时性和效率优化仍是研究重点,多个方向都在追求更快速的算法。

展望未来,我们可以预见计算机视觉领域将继续朝着更智能、更高效、更实用的方向发展。多模态AI、3D视觉、生成式AI等方向可能会成为未来研究的重点。同时,如何将这些先进技术落地到实际应用中,也将是一个重要的研究方向。

CVPR作为计算机视觉领域的顶级会议,汇聚了全球顶尖研究者的智慧结晶。本文总结的这些研究工作仅是冰山一角,相信随着会议的正式召开,我们将看到更多激动人心的研究成果。让我们共同期待CVPR 2024为计算机视觉领域带来的新突破和新机遇。

文章链接:www.dongaigc.com/a/cvpr-2024-papers-codes-summary

https:.//www.dongaigc.com/a/cvpr-2024-papers-codes-summary

开放原子开发者工作坊旨在鼓励更多人参与开源活动,与志同道合的开发者们相互交流开发经验、分享开发心得、获取前沿技术趋势。工作坊有多种形式的开发者活动,如meetup、训练营等,主打技术交流,干货满满,真诚地邀请各位开发者共同参与!

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)