【CVPR2023】Learning A Sparse Transformer Network for Effective Image Deraining

论文:https://readpaper.com/paper/4736105248993591297代码:https://github.com/cschenxiang/DRSformerTransformer 模型通常使用标准的 QKV 三件套进行计算,但是部分来自 K 的 token 与来自 Q 的 token 并不相关,如果仍然对这些 token 进行特征聚合计算会影响图像修复的性能。

论文:https://readpaper.com/paper/4736105248993591297

代码:https://github.com/cschenxiang/DRSformer

Transformer 模型通常使用标准的 QKV 三件套进行计算,但是部分来自 K 的 token 与来自 Q 的 token 并不相关,如果仍然对这些 token 进行特征聚合计算会影响图像修复的性能。

为了解决这个问题,该论文提出了一种Sparse Transformer网络(DRSformer),它可以自适应地保留最有用的自注意力值以进行特征聚合,从而更好地促进高质量的图像重建。论文框架如下图所示,个人感觉主要创新有两个方面:top-k sparse attention (TKSA) 和 mixed-scale feed-forward network (MSFN)。

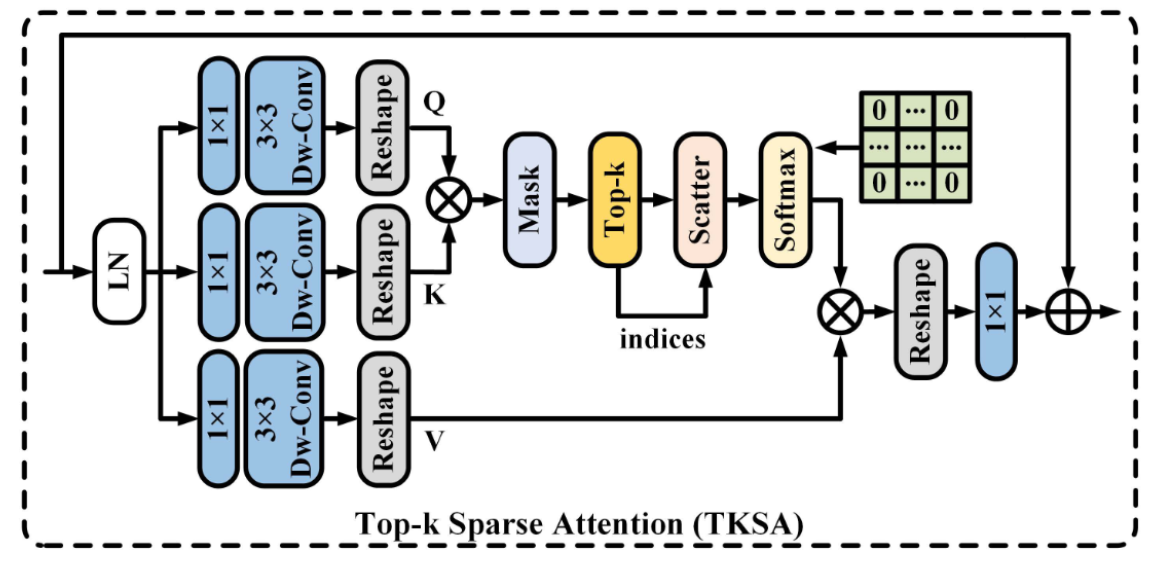

top-k sparse attention (TKSA)

TKSA如下图所示,大体沿用了 Restormer 的思路,不同之处在于作者创建了一个mask,把相对不重要的 token 置0了。这个算法的思路来自于 NeurIPS 21 的论文《Chasing Sparsity in Vision Transformers: An End-to-End Exploration》,原文中说,稀疏训练甚至可以提高ViT的准确性,而不是降低性能。

该论文还附一个 pytorch 的伪代码,具体如下。在这个去雨的任务中,通过实验作者保留了[1/2, 4/5] 区间的 token。

mixed-scale feed-forward network (MSFN)

MSFN的结构如下图所示,与Restormer里不同的地方是,作者使用两个尺度的卷积

实验部分可以参考作者论文,这里不过多介绍。

开放原子开发者工作坊旨在鼓励更多人参与开源活动,与志同道合的开发者们相互交流开发经验、分享开发心得、获取前沿技术趋势。工作坊有多种形式的开发者活动,如meetup、训练营等,主打技术交流,干货满满,真诚地邀请各位开发者共同参与!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)