【论文阅读】M3ED: Multi-modal Multi-scene Multi-labelEmotional Dialogue Database

根据文中的地址查看了一下数据集:https://github.com/AIM3-RUC/RUCM3EDSplitInfo是电视剧的名称,分别是训练集、验证集、测试集的剧集Annotation.json针对每一部电视剧,首先是说话的双方A、B的信息,包括名字、年龄、性别,然后对每一个片段分别有开始时间和结束时间、文本信息、说话者、情绪(三个注释者的情绪和最终的情绪)

论文地址:https://arxiv.org/abs/2205.10237

提出了一个数据集M3ED:一个庞大、多样、高质量、全面的多模态情感对话数据集,可以支持相关研究方向的更多探索,如多标签学习、对话中情感变化的可解释性、跨文化情绪识别等。

提出了一个通用的多模态对话感知交互框架 MDI:为情感识别的对话上下文建模,性能较优。

1.Introduction

ERC:对话中的情绪识别

多模态ERC需要对话上下文、场景、主体、主体的性格

本文构建一个大规模的多模态多场景多标签情感对话数据集M3ED,包含来自 56 部不同电视剧(500集)的 990 个二元情感对话视频片段。总共包含 24449 个话语,比 IEMOCAP 大三倍多,比 MELD 大近两倍。 M3ED 对话中存在丰富的情感交互现象,例如,分别有 5,396 和 2,696 个回合间情绪转移和情绪惯性场景,以及分别有 2,879 和 10,891 个回合内情绪转移和情绪惯性场景。是第一个大规模的中文多模态情感对话数据集,可以促进中文情感计算的研究。它也是跨文化情感分析和识别的一个有价值的补充。

Contributions

(1)构建了一个名为 M3ED 的大规模多模态多场景和多标签情感对话数据集,可以支持情感计算领域的更多探索。

(2)通过在 M3ED 上运行几种最先进的方法对数据集质量进行全面的完整性检查,实验结果证明了数据集的有效性和质量。

(3)提出了一个通用的多模态 Dialogue-aware 交互框架 MDI,它涉及多模态融合、全局-局部上下文和说话者交互建模,并且它实现了与其他最先进方法相当的性能。

2.related work

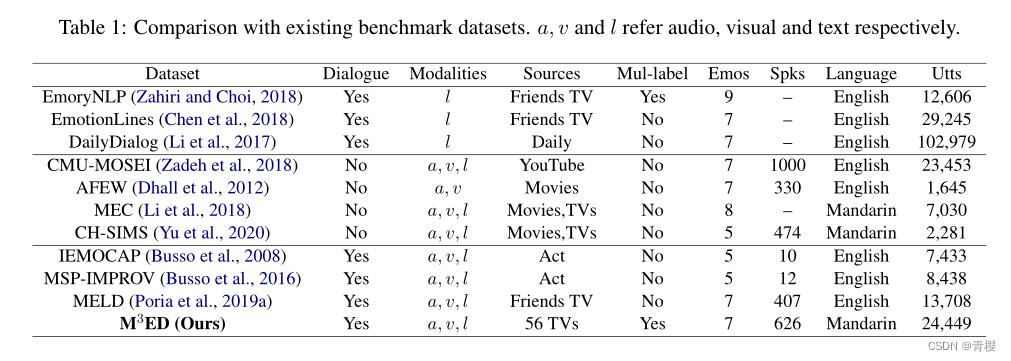

相关数据集:表1的一些情感数据集。第一组3个是纯文本模态的,第二组4个是多种模态但是不是会话式的不能支持对话情感分析的搜索,最后一组是当前可用的多模态情感对话数据集。

相关方法:以前关于 ERC 的工作重点是在与不同框架的对话中对上下文信息进行建模,捕捉对话上下文信息和情绪。

3.数据集构建

3.1对话选择

收集不同电视剧的对话片段,要求(1)类别是情感表达丰富自然的家庭、言情剧(2)每部电视剧15-25段高质量片段(3)每场对话至少有3轮互动,主题明确(4)选择面部表情清晰、声音清晰的两人对话场景。

在对话选择之后,随机检查每部电视剧的几个对话并过滤掉低质量的对话

3.2注释

为了方便情感标注的过程,要求人群工作者纠正文本内容并标注每个话语的说话者信息。视频没有字幕首先使用OCR方法生成文本内容和相应时间戳,对话中的第一个说话人被标注为“A”,另一个说话人被标注为“B”。此外,还注释了这些说话者的角色名称、年龄和性别。

我们根据 Ekman 的六种基本情绪(快乐、惊讶、悲伤、厌恶、愤怒和恐惧)和一个附加的情绪标签 neutral 来注释每个话语。观看视频后,要求注释者按顺序对话语进行注释,对话中的文本、听觉和视觉信息以及之前的话语可用于情感注释。允许注释者选择多个情绪标签来解释混合情绪(例如,愤怒和悲伤),这在现实生活中的人类互动中很常见。如果七种情感类别都不能准确描述话语的情感状态,则可以标注一个特殊的其他类别。对标注人员进行培训,并为其提供考试,只有通过考试的人员才能参与标注阶段。绝大多数数据集由大学生注释,所有注释者都是以普通话为母语的人。我们为每个对话分配了三个注释者。(这个数据集都是人工标注的)

3.3最终标注

我们对话语的所有注释应用多数表决策略来产生其最终的情感标签。一个话语分配多个情感标签的话,标签的重要性按降序排列。我们简单地按降序为每个话语的情感标签分配一个重要性值,例如第一个情感标签 I(e) = 7,第二个情感标签 I(e) = 6,依此类推。如果没有为话语分配标签,则其重要性值 I(e) = 0。

分析了注释者间的一致性,并针对七类情感问题实现了整体 Fleiss' Kappa统计量 k = 0.59,高于其他数据集

3.4数据集统计

情绪转移和情绪惯性是对话中的两个重要因素

89% 的话语被分配了一种情绪标签,11% 的话语被分配了混合情绪

4.模型框架

对话可以定义为一系列话语 D = {utt1, utt2, ..., uttN},其中 N 是话语的数量。每个话语由文本 (l)、声学 (a) 和视觉 (v) 模态组成。![]() 表示来自说话者A的话语uttt的话语级特征。

表示来自说话者A的话语uttt的话语级特征。

该任务旨在根据所有现有模态预测对话中每个话语的情绪状态。

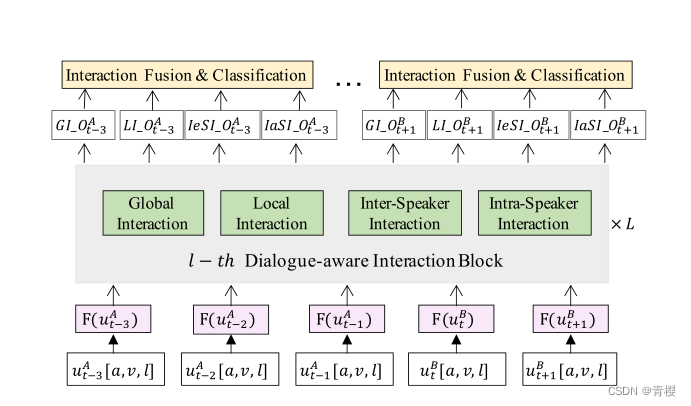

上图是多模态对话感知交互框架MDI,包含三个主要模块:

1) 多模态融合(Multimodal Fusion)模块旨在从不同的模态生成话语级多模态表示。

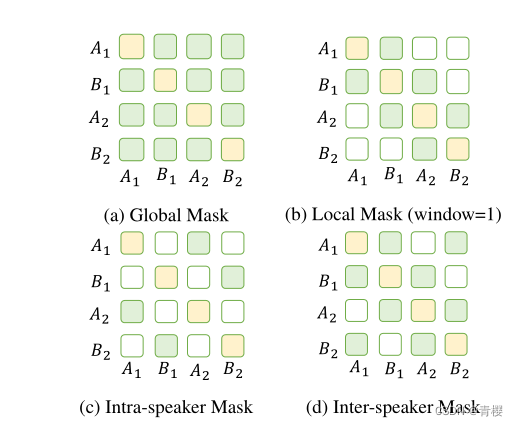

2) 对话感知交互(Dialog-aware Interaction) 模块旨在对对话中的交互进行建模。在每个块中采用四个子模块,Global Interaction、Local Interaction、Intra-speaker Interaction 和 Inter-speaker Interaction,分别对对话中的全局、局部、说话人内部和说话人之间的交互进行建模。我们通过巧妙地改变自我注意的掩蔽策略在一个 Transformer 层中实现这四种类型的交互,如下图

3) 交互融合和分类(Interaction Fusion and Classification)模块融合对话感知交互模块输出的不同交互信息,然后根据融合的交互信息进行情绪状态预测,通过简单的加法来融合对话感知交互模块产生携带各种交互上下文信息的不同输出,然后使用一个全连接层作为分类器,根据融合的交互信息来预测情绪状态。

5.实验

5.1特征提取:

研究了不同模式的最先进特征,包括用于情绪识别任务的文本、听觉和视觉特征

(1)文本特征:从预训练的 RoBERTa 模型中提取词级特征“L_Frm”。为了获得更有效的情感特征,我们从在 M3ED 上训练的微调 RoBERTa 模型中提取微调特征(“[CLS]”位置)“L_Utt”。

(2)声音特征:从预训练的 Wav2Vec2.0 模型中提取帧级特征“A_Frm”。我们从在 M3ED 上微调的 Wav2V ec2.0 模型中提取微调的特征(最后一个时间步长)“A_Utt”。

(3)视觉特征:我们首先提出了一种两阶段策略来检测说话者的面部。然后,我们通过预训练的 DenseNet 模型根据检测到的说话者的面部为每个话语提取面部特征“V_Frm”。DenseNet 在两个面部表情基准语料库 FER+和 AffectNet上进行了训练,对一个话语中的面部特征进行平均,以获得平均话语级特征“V_Utt”。

5.2baselines

在所提出的 M3ED 数据集上评估,包括话语级识别方法和对话级识别方法,

MultiEnc:一种灵活高效的话语级多模态情感识别框架(Zhao et al,2021),由多个模态特定编码器(分别用于声学、视觉和文本模态的 LSTM、LSTM 和 TextCNN)和一个融合编码器(多个全连接层)组成用于情绪预测。对于话语级模态特征,三个 DNN 编码器分别用于三种模态。

DialogueRNN:在 (Majumder et al, 2019) 中提出的最先进的基于 RNN 的 ERC 框架,它通过不同的 GRU 捕获全局和说话者特定的时间上下文信息以及全局情绪状态信息。对于多模态实验,这项工作采用了连接不同模态特征作为输入的早期融合方法。

DialogueGCN:在(Ghosal et al,2019)中提出的最先进的基于 GCN 的 ERC 框架,它分别通过直接边和不同的设计关系对长距离依赖和说话者交互进行建模。对于多模态实验,我们在这项工作中也采用了早期融合方法。

MMGCN:在 (Hu et al, 2021) 中提出的最先进的基于 GCN 的多模态 ERC 框架。对于单模态实验,我们只对全连接图建模。

5.3实验及结果

1)话语级实验:在不考虑对话上下文的情况下对孤立话语进行情感识别的话语级基线实验,旨在检查每种模态的质量并比较多模态信息对情感识别的有效性。采用 MultiEnc框架作为基线模型。

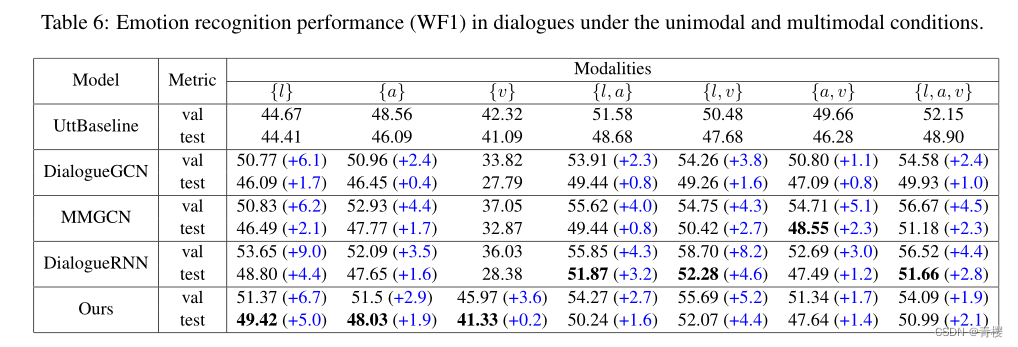

2)对话级实验:对话中情感识别的对话级实验,旨在将我们提出的通用 MDI 框架与情感识别的对话上下文建模中的最新模型进行比较。DialogueRNN、DialogueGCN 和 MMGCN 模型进行了比较。

结果:

多模态情感对话数据集两个因素:上下文信息和多模态都有显著的性能提升

单峰实验的性能很好,也就是说MDI单独的文本、声音、视频的结果比其他基线都好。证明了同时考虑全局和本地上下文交互以及说话人内部和说话人之间交互的四种对话感知交互策略比仅考虑这些交互的一部分具有更好的对话建模能力。

MDI 在多模态条件下并没有优于其他模型,这可能是由于训练数据集大小有限以及 vanilla 多模态融合策略在交互建模中的能力有限。

未来可以探索的方向:

微调的特征缺乏足够的模态特定信息,这限制了多模态条件下的性能。因此,基于原始帧级特征实现更高效的多模态融合模块,并使上述通用多模态对话感知交互(MDI)框架成为端到端模型,值得探索。

M3ED 数据集中存在丰富的情绪交互现象,包括回合间和回合内的情绪变化。情绪惯性和刺激是影响对话中说话者情绪状态的重要因素。情绪惯性和情绪刺激可以解释一个说话者的情绪如何影响他自己或另一个说话者的情绪。

混合情绪在人类现实生活对话中很常见,多标签学习有助于揭示和建模不同情绪之间的相关性。因此,M3ED 数据集可以支持对话中多标签情感识别的探索。

中文版 M3ED 数据集是对现有其他语言基准数据集的宝贵补充。它可以促进跨文化情感分析和识别的研究。

数据集介绍

根据文中的地址查看了一下数据集:https://github.com/AIM3-RUC/RUCM3ED

SplitInfo是电视剧的名称,分别是训练集、验证集、测试集的剧集

Annotation.json针对每一部电视剧,首先是说话的双方A、B的信息,包括名字、年龄、性别,然后对每一个片段分别有开始时间和结束时间、文本信息、说话者、情绪(三个注释者的情绪和最终的情绪)

Relation_annotation_release.json是一段时间内的对话Episode:表示回合,也就是这段时间内有多少回合对话,在零样本或小样本学习中广泛使用

M3ED Features里有四个文件,只是在细节上有一点差别,根据这个方式打开

https://blog.csdn.net/Dontla/article/details/103381523

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)