论文讨论|Agent-FLAN:通过精心设计训练语料,提升Agent表现,缓解幻觉问题

开源的大型语言模型(LLMs)在各种自然语言处理(NLP)任务中取得了巨大成功,然而,当作为代理时,它们仍然远远不如基于API的模型。如何将代理能力整合到通用LLMs中,成为一个关键且紧迫的问题。本文首先提出了三个关键观察:(1)当前的代理训练语料库同时包含格式遵循与代理推理内容,这与预训练数据的分布显著偏离;(2)LLMs在代理任务所需的能力上展现出不同的学习速度;(3)当前的方法在提升代理能力

论文链接

标题:Agent-FLAN: Designing Data and Methods of Effective Agent Tuning for Large Language Models

地址:https://arxiv.org/abs/2403.12881v1

摘要/Abstract

中文翻译版:

开源的大型语言模型(LLMs)在各种自然语言处理(NLP)任务中取得了巨大成功,然而,当作为代理时,它们仍然远远不如基于API的模型。如何将代理能力整合到通用LLMs中,成为一个关键且紧迫的问题。本文首先提出了三个关键观察:(1)当前的代理训练语料库同时包含格式遵循与代理推理内容,这与预训练数据的分布显著偏离;(2)LLMs在代理任务所需的能力上展现出不同的学习速度;(3)当前的方法在提升代理能力时引入了幻觉等副作用。基于上述发现,我们提出了Agent-FLAN,旨在有效地为代理微调语言模型。通过仔细地分解和重新设计训练语料库,Agent-FLAN使得Llama2-7B在各种代理评估数据集上的性能比之前的最佳工作提高了3.5%。通过构建全面的负面样本,Agent-FLAN大大缓解了基于我们建立的评估基准的幻觉问题。此外,它在增大模型规模的同时持续提升了LLMs的代理能力,同时略微增强了LLMs的通用能力。代码将在https://github.com/InternLM/Agent-FLAN提供。

英文原版:

Open-sourced Large Language Models (LLMs) have achieved great success in various NLP tasks, however, they are still far inferior to API-based models when acting as agents. How to integrate agent ability into general LLMs becomes a crucial and urgent problem. This paper first delivers three key observations: (1) the current agent training corpus is entangled with both formats following and agent reasoning, which significantly shifts from the distribution of its pre-training data; (2) LLMs exhibit different learning speeds on the capabilities required by agent tasks; and (3) current approaches have side-effects when improving agent abilities by introducing hallucinations. Based on the above findings, we propose Agent-FLAN to effectively Fine-tune LANguage models for Agents. Through careful decomposition and redesign of the training corpus, Agent-FLAN enables Llama2-7B to outperform prior best works by 3.5\% across various agent evaluation datasets. With comprehensively constructed negative samples, Agent-FLAN greatly alleviates the hallucination issues based on our established evaluation benchmark. Besides, it consistently improves the agent capability of LLMs when scaling model sizes while slightly enhancing the general capability of LLMs. The code will be available at this https URL.

内容讨论

从论文内容中看,作者探讨了如何从调整训练数据的角度提升agent的表现,同时缓解幻觉问题。具体包括:

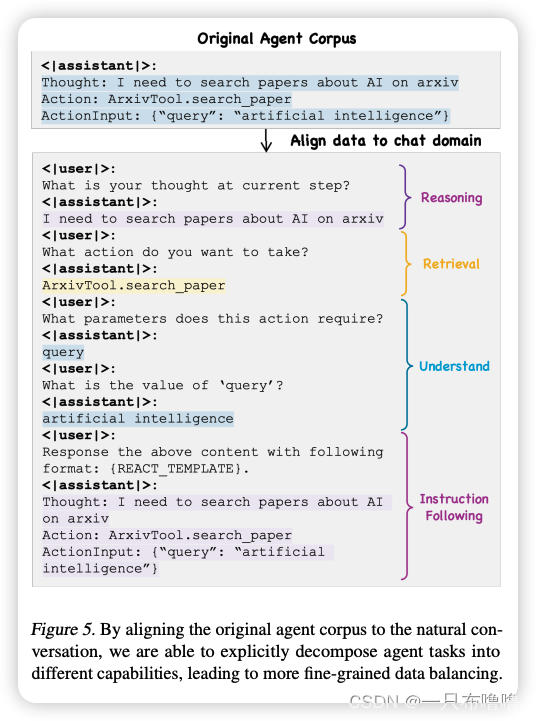

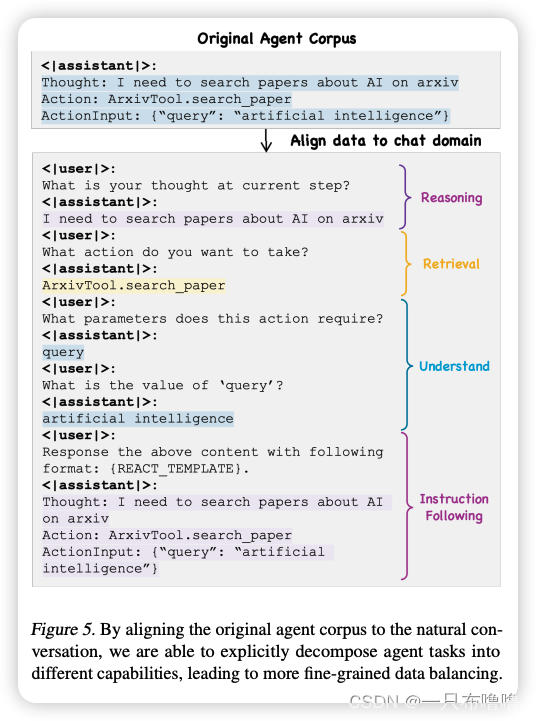

1.(论文4.1节)将agent微调数据从ReAct、JSON等形式转化为自然对话的形式,从而和预训练数据的格式对齐:Table 2可以观察到对齐后的效果提升。

2.(论文4.2节)将训练数据按推理、检索、理解、指令遵循的能力分类进行拆分,并做data balancing:Table 2显示了推理和理解是最有益的混合成分,其次是检索和指令遵循:当将推理和理解数据的比例减少到50%时,最终性能分别下降了1.1/0.3个百分点。而通过减少检索和指令遵循的数量,性能几乎不受影响,甚至有所提升。这和前文Figure3展示的检索和指令遵循的损失下降速度比推理和理解快得多的观察一致。

3.(论文4.3节)构建负样本:发现在大部分情况下,训练数据只包含了Figure6中的(a)(d)两类,而忽略了(b)(c)的情况,这导致训练出的模型很难泛化到这类请求。Table3展示了在增加了负样本后,幻觉问题被大大缓解。

思考:能否学习到一些数据上应该进行的系统性工作?

我们发现,在AI领域内,尽管大家普遍认识到了数据的重要性,但到目前为止,我们仍然缺乏系统方法来构建AI数据。无论是训练还是测试,当前数据的迭代仍然是启发式的,强依赖于人工和经验。这不仅阻碍了我们通过数据提升模型表现的过程,也导致了大量成本和时间的浪费——毕竟每一笔数据生产都是要花钱、花时间的。解决这个问题,正是我们开始这份工作的初衷。

因此,我们非常希望能与大家深入探讨和系统建设AI数据有关的任何话题。具体到这篇论文来说,我们是否能找到一套系统化地识别数据格式、分布及负样本等问题的方法?或者,这些问题是否只是某一更大问题下的细分问题呢?

此外,我们目前的工作重点是构建一个专门面向AI工作者的领域知识管理平台,这基于我们自己的一个认识:对领域知识的共识是AI数据复用、建设高质量AI数据集的前提。我们也非常期待与大家讨论这是否是一个正确的方向。

总而言之,我们期待大家的任何反馈。提前感谢大家🎉

也欢迎大家关注我们的公众号,或者直接添加我们的微信联系,再次感谢🎉

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)