win10+idea+spark+scala+sbt配置

最近刚刚在学习spark,涉及到配置sbt,焦头烂额,遇到了各种问题,这里详细讲讲这些问题(不讲具体怎么配置,个人经验)。环境:win 10 x64idea 社区版hadoop 2.7.2spark 2.4.5spark2.4.5下载官网scala 2.11.8如果什么都没有装的,可以看看这篇文章:https://blog.csdn.net/a1066196847/article...

最近刚刚在学习spark,涉及到配置sbt,焦头烂额,遇到了各种问题,这里详细讲讲这些问题(不讲具体怎么配置,个人经验)。

环境:

win 10 x64

idea 社区版

hadoop 2.7.2

spark 2.4.5 spark2.4.5下载官网

scala 2.11.8

如果什么都没有装的,可以看看这篇文章:https://blog.csdn.net/a1066196847/article/details/87923496

这里说一下,一定要看spark官网的文档:

首先是Note that那里,看一下spark依赖的scala版本,别下载最新的scala,记住是2.11开头的。然后是最下面的groupID,artifactID,version,后面在idea中有用。

关于spark和hadoop

过程不再赘述,看这个链接:https://blog.csdn.net/a1066196847/article/details/87923496

这里讲几个我遇到的问题:

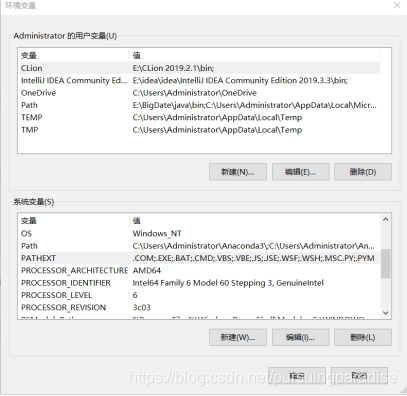

1.由于之前已经安装了pycharm,但是没有配置python的环境变量,这里注意要在环境变量中加上

C:\Users\Administrator\Anaconda3

C:\Users\Administrator\Anaconda3\Scripts

另外在PATHEXT中加上PY;.PYM

2.关于spark-shell命令后出现系统找不到路径的问题:

可能原因较多,但较隐蔽的问题出现于%JAVA_HOME%的设定上有问题,注意要先把Path中jdk安装时默认添加的路径删掉,然后检查%JAVA_HOME%对不对(这点基本上是最关键的原因,如果不是可以试试把path中的SPARK_HOME上移)。

关于IDEA配置SBT和scala

重灾区:一定要耐心,等SBT的dump结束,不过如果build日志里显示一个进程一直卡着,比如卡了1个小时,那就肯定是有问题了。补充一点,打开sbt项目后第一时间打开build.sbt添加spark依赖,格式是下面第五条,注意和之前的配置要空一行。

1.关于dump structure from sbt很慢,网上有很多教程说是改变sbt的源,但我试了很多个方案,有说源变了,然后配置文件也各不相同,我索性直接翻墙了,不过如果能够改变源的话那自然最好。

2.idea的buildlog中显示:Waiting for lock on C:\Users\Administrator.ivy2.sbt.ivy.lock to be available…

解决方案:在资源管理器中找到所有java进程并关闭

3.卡在idea卡在Loading project definition from C:\Users\Administrator\IdeaProjects\untitled3\project

解决方案:利用cmd命令 attrib 文件夹路径 -r 将相应文件夹的只读属性去除

4.版本匹配非常重要,一定要等idea的dump project完成(改变国内源的方法都未成功,所以考虑翻墙解决)

5.Build.sbt中的spark依赖libraryDependencies += “org.apache.spark” % “spark-core_2.11” % “2.4.5”

6.记得创建scala的SDK:file–project structure–global library–会有自动检测,选择和你一样的scala版本

7.在build过程中若出现:

FetchError$DownloadingArtifacts: Error fetching artifacts:

解决方案:C:\Users\59404\AppData\Local\Temp目录下的内容清理一下(全删,若在使用的则保留)

8.出现“wrong checksum”,在日志所示的文件夹下,我的是C:\Users\Administrator\AppData\Local\Coursier\cache\v1\https\repo1.maven.org\maven2\org\apache\hadoop\hadoop-hdfs\2.6.5,显示首部校验和错误

解决方案:我将其中改变日期不属于当天的全删掉,然后又显示有个jar包不存在,所以把回收站中的jar包又还原,再次build成功。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)