Windows下的spark环境的搭建

*注在搭建spark环境时需要配置好JDK直接在http://spark.apache.org/downloads.html下载spark添加spark环境变量D:\spark-2.2.0-bin-hadoop2.7\bin新建hadoop文件,在hadoop文件下新建bin目录去 https://github.com/steveloughran/winutils 选择你对应的h

·

*注

在搭建spark环境时需要配置好JDK

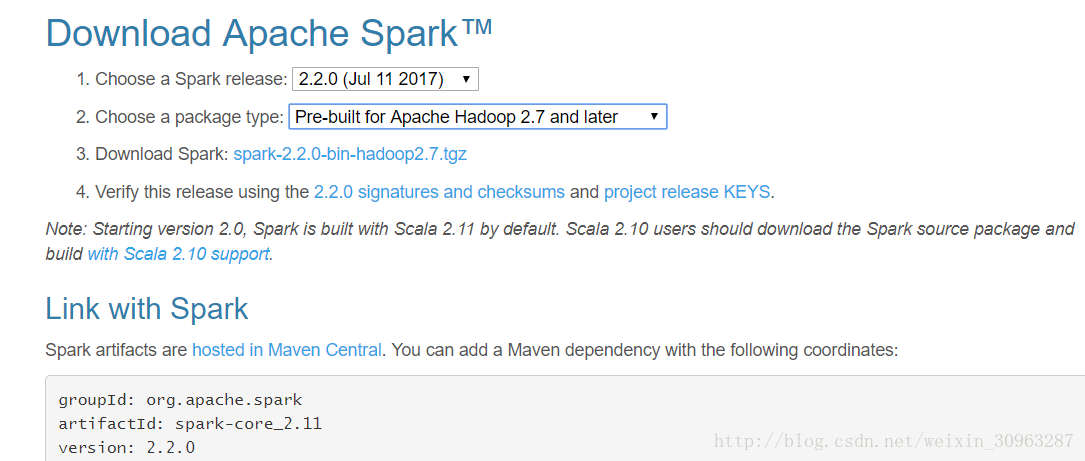

直接在http://spark.apache.org/downloads.html下载spark

添加spark环境变量

D:\spark-2.2.0-bin-hadoop2.7\bin

新建hadoop文件,在hadoop文件下新建bin目录

去 https://github.com/steveloughran/winutils 选择你对应的hadoop版本号,下载到bin目录下

添加hadoop环境变量

D:\hadoop\bin

建立一个系统环境变量HADOOP_HOME

将D:\hadoop添加进去

修改winutils权限

%HADOOP_HOME%\bin\winutils.exe chmod 777 \tmp\hive

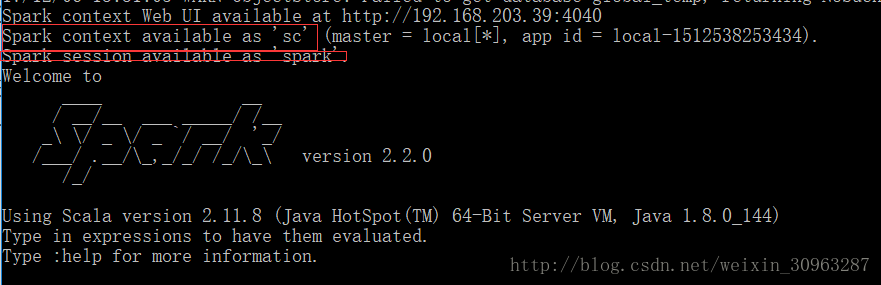

在 cmd中输入spark-shell

若出现

Spark context available as sc.

Spark session available as spark

则环境配置成功

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)